Le tout premier laboratoire d’expérimentation NFB/ONFxp se conclut sur des présentations éclair inspirantes

Le tout premier laboratoire d’expérimentation NFB/ONFxp se conclut sur des présentations éclair inspirantes

Lancé à la fin de février, le laboratoire d’expérimentation NFB/ONFxp a ouvert ses portes à quatre artistes innovateurs qui ont ainsi eu l’occasion de tester leurs idées les plus folles, de repousser les limites de leur imagination et d’établir des liens avec des professionnels chevronnés dans des secteurs connexes, sur la même longueur d’onde qu’eux.

Dirigé par le Studio d’animation anglais, le laboratoire a soutenu les artistes en les jumelant à des mentors qui les ont guidés dans leur processus de création et en les faisant bénéficier de l’équipement et des ressources nécessaires pour mener à bien leur expérimentation. Le 10 avril, au bout de seulement six semaines d’essais et de tribulations, ces quatre ambitieux créateurs ont dévoilé leurs expériences et communiqué ce qui en est ressorti devant une salle comble à l’Espace ludique – à deux pas du futur siège social de l’ONF, au centre-ville de Montréal.

Shawn Laptiste

Selon sa proposition initiale intitulée Cellular Automata, Shawn envisageait de créer une application de réalité augmentée grâce à laquelle un téléphone cellulaire agirait comme un pixel parmi des centaines d’autres pour créer une immense image animée. Espérant créer un nouveau médium qui permettrait aux artistes d’exposer leurs œuvres, Shawn a commencé à explorer le moyen le plus logique d’installer l’outil sur les appareils du public. Son idée a considérablement évolué depuis. Au cours d’une réunion avec Frank Nadeau (ingénieur, Développement et technologie médias à l’ONF), Shawn a eu un éclair de génie qui a bouleversé le cours du projet :

« Il m’a suggéré d’utiliser une caméra pour voir les téléphones cellulaires et faire en sorte que ce flux vidéo détermine ce qui s’afficherait à l’écran des appareils. Ainsi, le développement passerait non plus par la triangulation et le positionnement, mais bien par la vision par ordinateur. »

Grâce à cette nouvelle orientation, l’affichage n’exigeait plus que les membres du public téléchargent une application sur leur cellulaire, ce qui simplifiait les choses : plus besoin de prendre le temps de télécharger, d’utiliser les données individuelles pour le téléchargement ni de demander des autorisations. Cette approche aurait vraisemblablement dissuadé un auditoire par ailleurs intéressé.

Adoptant ce nouvel angle d’expérimentation, Shawn s’est alors appliqué à perfectionner son algorithme génétique pour que chaque téléphone détermine les pixels colorés qu’il doit afficher. Shawn a aussi travaillé à cerner la meilleure façon de recevoir et de rafraîchir les données visuelles sur les appareils. Qu’en serait-il dans la pratique, quand l’auditoire se multiplie ou diminue à mesure que les gens partent ou se joignent au public? Le nombre d’appareils affichant l’œuvre peut varier à n’importe quel moment : le programme s’adapte en rafraîchissant et en ajustant la taille de l’image en fonction du nombre et de l’emplacement des téléphones détectés.

« Selon cette méthode, la caméra et les téléphones forment une boucle de rétroaction : la caméra lit ce qui s’affiche sur les appareils et le système tente de créer la meilleure image en ajustant l’entrée de données visuelles cadre par cadre. »

Vers la fin du laboratoire, Shawn s’est concentré sur l’accélération du traitement en optimisant et en parachevant l’application Web qui communique avec le serveur. Même s’il reconnaît qu’il y a encore 1000 petits détails à régler, Shawn a conclu sa présentation en beauté par la démonstration du premier prototype qu’il a testé avec l’auditoire. Un petit peu de travail d’équipe, et les membres du public enthousiaste créaient ainsi une petite de mer de couleurs en brandissant leurs téléphones cellulaires.

On peut suivre Shawn sur Instagram, Twitter, GitHub et itch.io : @lazerfalcon.

Kofi Oduro

En utilisant l’intelligence artificielle (IA) pour jouer avec les sens des gens, l’expérience en RV de Kofi, Diluted: Am I In Control?, évoque le sentiment d’être perdu. Piégé dans un espace abstrait sans avoir d’objectif évident, le joueur décide de ce qu’il fait ensuite : essayer de s’échapper sur-le-champ ou se contenter d’explorer? L’IA adapte l’expérience au choix du joueur.

« Au cours de ma première réunion [avec Stéphanie Bouchard (fondatrice et chef de la direction de Stockholm Syndrome.AI)], nous avons établi le genre d’interactions qui seraient provoquées par le monde ambiant et celles qui le seraient par le joueur. J’espère aussi approfondir l’esthétique et choisir le type de scripts et d’algorithmes que je veux employer pour façonner ce monde immersif. »

En collaboration avec Stéphanie, Kofi a clarifié le canevas narratif et le parcours de l’utilisateur dans l’expérience qu’il voulait créer. Plein d’idées bouillonnaient dans sa tête lorsqu’il est entré dans le laboratoire, et son premier défi a été de sélectionner celles qui auraient le plus d’effet sur l’expérience et sur le joueur. À grand renfort de scénarimages et de mappage, ils ont déterminé ce que verrait le joueur, le genre d’objets qu’il rencontrerait sur son passage et le type d’action qu’il déclencherait en interagissant avec eux. Ayant ainsi étoffé l’expérience du joueur, Kofi a été en mesure d’explorer et de préciser quels outils seraient les plus avantageux. Il a opté pour Unity (moteur de jeu multiplateforme en temps réel) et Bolt (logiciel de programmation visuelle compatible avec Unity, créé par la firme montréalaise Ludiq). Kofi travaille encore à greffer un schéma narratif à ramifications qui procure à chaque joueur une expérience unique mais, ce mercredi soir, l’auditoire était enchanté de l’avant-goût dont il a profité avec la démo en RV délirante qui lui a été présentée!

Le site Web de Kofi se trouve ici.

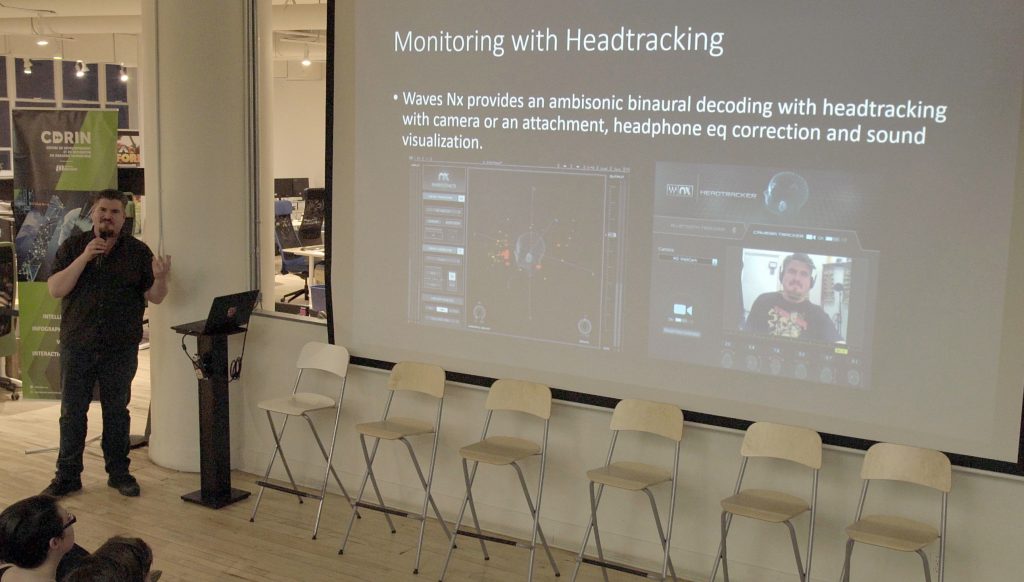

Travis Mercredi

Travis s’était d’abord proposé de créer un paysage et un espace sonores réactifs, capables de susciter un sentiment d’immersion plus intense à l’aide de séquences audio et vidéo enregistrées dans les Territoires du Nord-Ouest. Il voulait surtout apprendre. Formé à la conception sonore traditionnelle, il souhaitait vraiment élargir ses connaissances et ses compétences en vidéo 360˚ et en réalité virtuelle (RV). Il a commencé par expérimenter et étudier le flux et les processus de production du son spatialisé. Dès le début, le gros problème de Travis a été de trouver le bon logiciel qui réponde à ses besoins ainsi que le traitement et le flux les plus efficaces :

« Je suis venu ici dans l’intention de réorienter mon travail. J’ai des antécédents en conception sonore et en postproduction, mais ce qui m’intéressait le plus était des trucs qui n’existaient pas à l’époque. D’une certaine façon, je me sens comme un intrus. Je vais assimiler cette expérience à l’ONF, et je vais retourner dans mon Nord. Je suis comme un canal. »

Dans son projet, Travis avait pour objectif d’explorer les limites de l’expérience vidéo 360˚, de fusionner le flux de données issu de son travail en postproduction et de laisser aller sa créativité dans un médium qu’il connaît moins bien.

« D’une certaine façon, j’espérais trouver une plateforme plus adaptée à ce que je voulais faire, mais j’ai constaté que nous n’en sommes pas encore là, compte tenu des options logicielles offertes sur le marché. Elles ciblent toutes des domaines et des fonctionnalités différentes, certaines étant plus utiles que d’autres dans le flux vidéo de postproduction. »

Travis a fini par utiliser Reaper (poste de travail audionumérique créé par la société Cockos, associé à un séquenceur MIDI), et il recommande hautement le produit à quiconque souhaite travailler les données audio. En recourant au système Ambisonics — un appareil semblable à une sphère qui capte les sons d’ambiance — Travis a pu enregistrer les sons de la séquence qu’il avait choisie et les fusionner à ses plans vidéo 360˚ pour créer une expérience immersive. Une fois les présentations terminées, l’assistance a eu droit à un aperçu de son paysage sonore!

Le site Web de Travis se trouve ici.

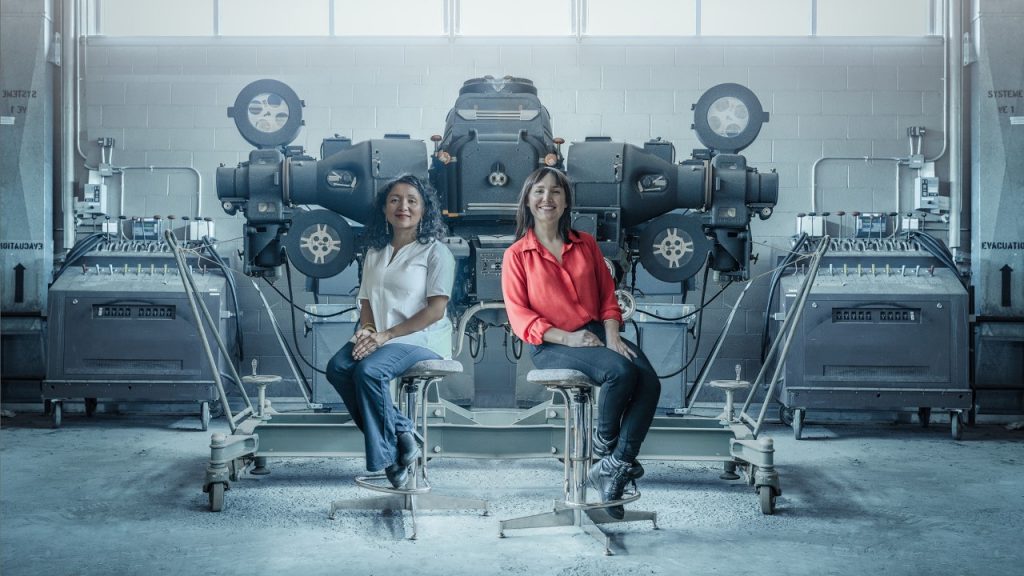

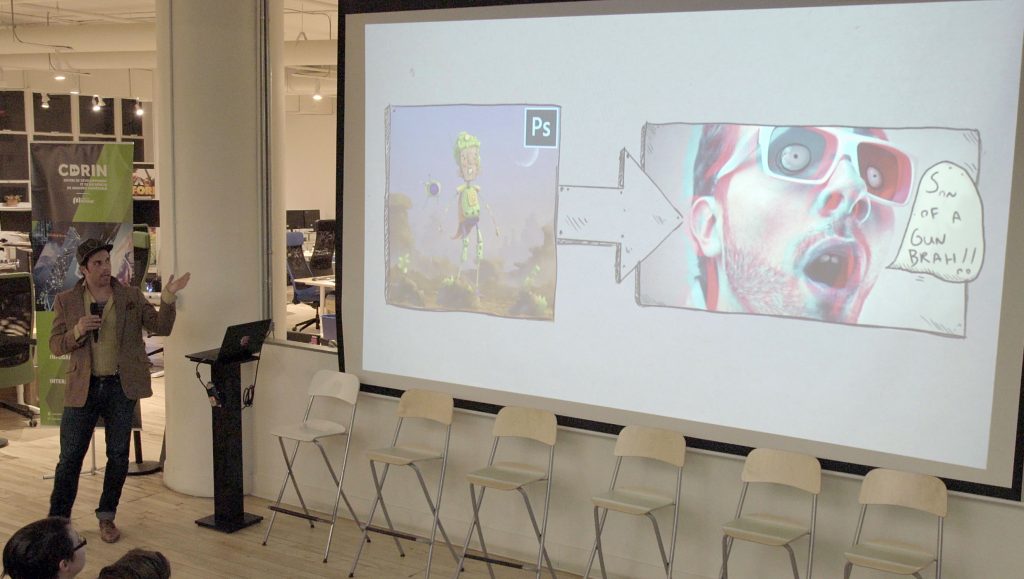

e→d films

À la fin de mars, au bureau central de l’ONF, e→d films a fait un test bêta spécial de son tout nouveau module d’extension, 2D to 3D, qui facilite, de façon inédite et emballante, le processus de travail entre PhotoShop et les logiciels 2D. L’outil est avant tout destiné aux artistes qui sont peu familiarisés avec la 3D ou insatisfaits des processus actuels de production 3D. NFB/ONFxp a fourni l’espace, le matériel nécessaire et six artistes qui brûlaient d’envie d’essayer ce nouvel outil. Daniel Gies a dirigé l’atelier — aidant ainsi les participants à se familiariser avec le nouveau module d’extension — et ses assistants David Barlow-Krelina et Roxann Veaudry-Read circulaient pour répondre aux questions et résoudre les problèmes. Une fois que les six participants ont compris les possibilités de l’outil, ils se sont attelés à donner vie à leurs créations respectives.

« Nous voulions voir comment tirer parti du meilleur de la 3D et de la 2D puis les amalgamer pour éviter le lourd processus d’apprentissage de la 3D. Comme la 3D est vraiment un défi de taille, nous avons eu l’idée de combiner simplement Photoshop à des lunettes 3D! Plutôt que de faire de la 3D en bonne et due forme, on peut faire un peu de 3D et voir ce qui se passe. » – Dan Gies, directeur artistique d’e→d films

Quand le test bêta sur trois jours a été terminé, les participants ont fait part de leur travail au groupe, communiqué leurs dernières observations, présenté l’œuvre créée avec le module d’extension et mentionné les bogues qu’ils avaient détectés, le cas échéant. « [Nous sommes venus à l’ONF] donner cet atelier pour voir si le processus fonctionnait. Savoir ce que les artistes pouvaient en tirer et quels problèmes ils rencontraient. Et nous avons ainsi pu observer leur processus en temps réel et leur façon d’aborder différents outils. » – Dan Gies

L’atelier s’est avéré un succès non seulement parce qu’il a procuré des informations extrêmement utiles à e→d films, mais aussi parce qu’il a incité les artistes participants à repousser les limites de leur travail et de leurs façons de faire.

Les films d’e→d se trouvent dans le site Web de l’entreprise, ici, et sur les médias sociaux à @e.d.films.

Vous aimeriez faire un test bêta du nouveau module d’extension d’e→d films? Envoyez un courriel à l’entreprise à l’adresse info@edfilms.net.

À la séance de questions et de discussion qui a suivi le laboratoire d’expérimentation, la première question posée a été « qu’est-ce qui viendra ensuite? » Tous les créateurs se sont montrés passionnés par leurs nouveaux projets et ont affirmé qu’ils les poursuivraient. Les organisateurs de NFB/ONFxp espèrent que tous les membres de l’assistance (sur place ou sur Facebook Live) se sont sentis inspirés et se sont mis à rêver de leurs propres projets de création à venir.

Pour en apprendre davantage sur le laboratoire d’expérimentation et ses tout premiers participants, consultez ici le premier billet de blogue sur NFB/ONFxp.